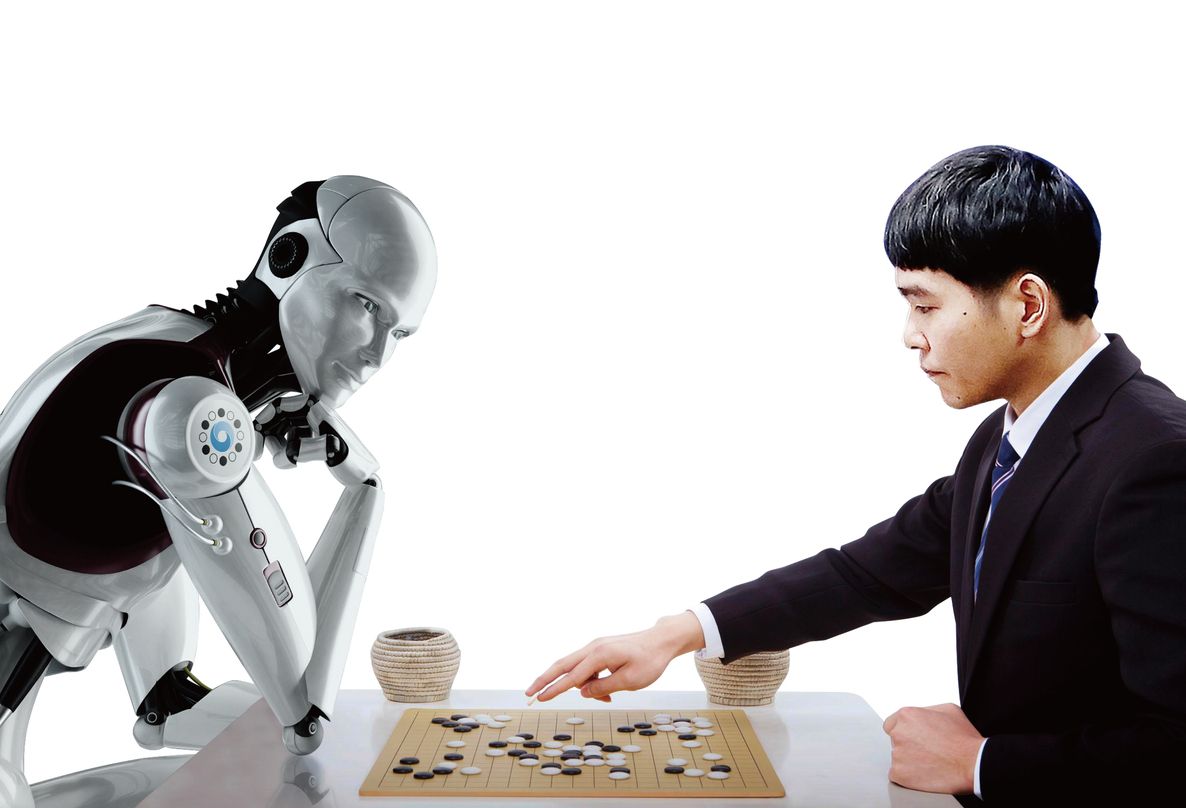

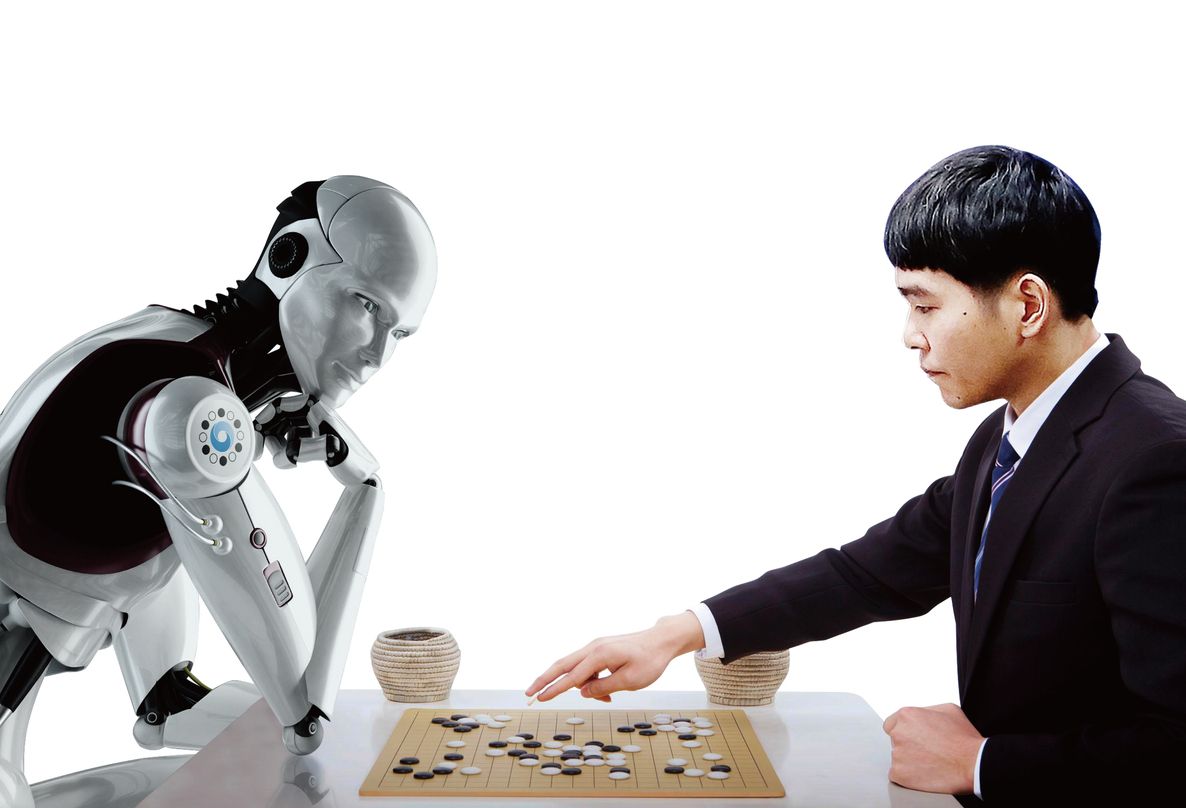

2016年3月,Google旗下的DeepMind研发的AlphaGo 4:1战胜了围棋九段李世石,引起了全世界范围的轰动。2016年底,AlphaGo又以Master的身份复出,与中日韩数十位高手进行快棋对决,连续60局AI大获全胜。这回柯洁也无话可说了。

紧接着,卡内基梅隆大学研发的Libratus又在德州扑克战胜了4位全球顶级职业玩家。与围棋不同,德州扑克属于不对称信息游戏,玩家要猜测对方手牌,还要猜测对方的心思。输的钱最少的金东(Dong Kim)赛后表示,比赛之前完全没有想到AI这么强大,跟开挂了一样似乎能够看到自己的手牌。

虽然像Google,Facebook,Microsoft,Apple这些顶尖互联网公司都在大力布局AI和深度学习,但是在现实生活中并没有出现AI的大规模应用。我们每天接触的AI,也不过是无聊的时候调戏一下Siri。

AI之所以未能在日常生主要活中普及,很大程度上是因为绝大多数互联网公司都在脱离产业去研发底层算法。

换句话说,懂AI和深度学习技术的科学家,不了解产业内的实际问题,而产业内的企业,对AI这类技术也是不敢触及。因此我们将在日后持续与你探讨AI对各个产业的改造,今天我们和星河互联高级投资经理胡天硕一起为大家分享教育+AI的机会在哪里,希望对你有所帮助。

以下,供你参考。

第一 深度学习到底是什么?

AlphaGo,Libratus还有各种自动驾驶技术有什么共性呢?那就是运用最新的深度学习(Deep Learning)算法。深度学习涉及到的较深的数学知识,同时考虑到读者未必有深厚的理工科背景,我尽可能以一种最通俗易懂的方式来介绍一下深度学习。

传统的机器学习(Machine Learning)一般用于处理那些具有简单规律的数字。例如,已知这几年的全球变暖,预测未来的趋势,或者是那些喜欢周杰伦歌的用户还会喜欢谁的歌曲。而对于许多复杂的数据,就很难用简单的数学公式来回答了。例如我们如果为猫的样子找一个数学公式,那一定是非常复杂的,因为可能存在黑猫、白猫、花猫,坐着的、躺着的和正在捕老鼠的——然而深度学习就可以做到对图像、声音、文字等复杂对象的识别和分析。

深度学习这个技术,我们记住以下几点就行了。

1. 深度学习能够把两种不同的复杂的数据关联起来

只要有足够多的图片标注好其对应的文字,通过深度学习就可以预测类似图片所对应的文字了。

把图片替换成声音,深度学习就由图片识别变为声音识别。如果标注的是声音对应的正文,就可以做语音识别,如果标注的是讲话的人,就可以做声纹识别。把对应的过程颠倒过来,就可以做语音合成。

不仅图像可以和文字对应,图像还可以和图像自己对应,例如可以把素描的图像与真实照片对应,或者是把真实照片与艺术照对应。

文字也可以与文字进行对应。中文对应成英文,就可以做翻译。把长的新闻报道与其总结做对应就可以自动生成新闻标题。把说话与其潜在的回应对应,就可以做聊天机器人。排列组合的情况非常多,例如自动驾驶技术的基本原理就是图片与方向盘/油门/刹车的对应。当然实践中,并不是简单这么一下就对应出来的,需要用到不同类型的深度学习网络例如CNN/RNN/LSTM/GAN等等,在这里就不展开了,有兴趣了解的可以去网上搜一下。

2. 相比于人的学习,深度学习需要非常多倍的数据量

目前深度学习的一大瓶颈就是想要准确率高,就得有大量的人工标注数据(supervised learning)。举一个例子,一个从未见过袋鼠的人,只需要看一只袋鼠的一两张照片就能识别出接下来看到的照片是不是袋鼠。而在imagenet里,每一个标注的类别(例如袋鼠、卡车)都需要出现上千遍,电脑才能学会。同样,DeepMind训练电脑玩游戏,都是几千盘后电脑才能学会,而一般人十几盘就已经上手了。就算是Alphago,Libratus能下得过顶尖人类高手,可是他们跟自己下的盘数远远超过顶尖高手这辈子下的棋盘个数。

从这个角度来讲,深度学习是比人要更“笨”的,在同样数据量的情况下,深度学习算法的总结归纳能力是更弱的——未来的算法(所谓One-shot Learning)应该会在这个方向上有所突破。

3. 不仅深度学习工具是开源免费的,绝大多数深度学习算法甚至模型都是开源的

深度学习领域这几年的发展速度迅猛,绝大多数科研从业者已经摒弃了传统发论文、审论文几个月的周期,而是第一时间会把自己的论文公开上传到国外的Arxiv网站。这大幅度加快了传统科研的速度,往往刚一出来新的结果,不到几周的时间,就有更新的结果超越了原有的算法。不仅如此,大量的代码被开源放在Github上(之前的所有示例都可以在Github上找到开源项目),于是企业运用AI的时候,绝大多数不需要去做算法上的基础研究,而只需要去调研并使用国际上最新的科研结构即可。企业完全可以把底层的深度学习工具当做一个黑盒直接去使用,真正做的工作不过是建立足够多的人工标注数据以及对于深度学习原始结果的简单加工和封装。

4. 深度学习距离真正的通用AI还很遥远

深度学习目前就像一个把3-4岁的小孩,能够汽车的图片,汽车这个单词,还有汽车的声音建立联系。本质上它能够把复杂数据对应起来,但是还有许多是做不到的,例如:

与人进行有意义的对话

写出具有逻辑性的文章

在即将发生车祸时,做出道德判断

编写计算机程序

但这并不妨碍我们在这个阶段里在产业中使用深度学习。

第二 AI怎么和教育进行结合?

在前一部分我们解释了基于深度学习的AI有哪些潜力。这部分我们从图像、声音、文字、自适应学习几个不同的角度来看深度学习与教育产业的结合点有哪些。

2.1 图像篇

目前使用图像识别最主流的应用就是拍照搜题,典型代表是作业帮、学霸君、小猿搜题、阿凡题……

传统的K12应用更多是停留在学生需要主动上来去看视频和做题,这本身对于学生来讲是很难有学习场景的。而拍照搜题则是学生带着问题和困惑来学习的,所以我们也看到拍照搜题App是所有K12应用里活跃度最高的。拍照搜题的核心技术就是把图片与文字做对应在,然后再去做文字与已有题库的匹配,上文中我们也提到由于开源技术的普及,图像识别已经不再有之前的门槛了,现在最大的门槛反倒是品牌和题库的大小。

当然拍照搜题本身是非常具有争议性的。如果学生是在遇到困难并且思考后,通过手机获得答案,这是一个很好的自主学习过程。但如果是无脑地把所有答案抄到练习册上,就没有任何学习意义了。不轮争议的结果如何,有一件事情是值得肯定得,那就是拍照搜题打破了只有老师才有标准答案的垄断,老师在布置作业时,面临的思考是,当所有学生都有正确答案时,怎么让学生认真去练习。

除了拍题识别以外,手写识别准确率也逐渐在提高,有一些专门的企业还会做针对公式、科学符号的识别,这里也就不展开了。

未来可以预见到的图像识别与教育结合的三点:

2.1.1 打通纸质书籍与在线教育

几千年来,传统纸质书籍承载了几乎全部的人类知识。然而这些纸上的图文知识与互动性强/展现形式丰富的在线教育形成了明显的反差。虽然现在的AR书籍都是以AR作为噱头。但图像识别和增强现实有潜力让过去的纸质书籍再次迎来新生,让他们在彻底消失之前,成为作者与读者、读者与读者之间一个全新的学习交流渠道。有了足够强大的图像识别技术,书无需嵌入二维码,书的内容本身就是“二维码”。《丑小鸭》变成了3D的游戏,《新概念》可以直接评判自己朗读的水平,《红楼梦》的经典段落有着上万名读者的批阅,《三体》则直接可以和大刘线上交流。

2.1.2 打通真实可见的世界与在线教育

微软之前推出一个App《微软识花》,虽然交互体验和识别率都不够理想,但是它代表了一种新的学习方式,所见即所学,或者即时学习(Just-in-time learning)。未来一定会有底层的技术提供商以较高的准确率和较低的延迟识别画面里的物体——学习语言和科学,不再是围绕着“单词”或“概念”,而是更加围绕用户所在的真实“场景”。

2.1.3 动作捕捉与在线教育

大量的体育、乐器、武术、舞蹈、绘画难以做在线教育的根本原因是因为缺乏教学者对学习者的姿态给出及时有效的反馈。随着视觉动作捕捉技术的成熟,成本逐渐下降(当然也不排除基于可穿戴设备的方案),每一个学习者都能享受顶尖AI教练一对一的个性化指导。

对于教育机构来讲,动作捕捉,尤其是人脸捕捉是保护自己IP的全新方式。机构对名师那是又爱又恨——名师可以带来大量优质生源,也可以随时把优质生源带走。可是如果展现在学生面前的不是一个真实面孔,而是一个例如“初音未来”的虚拟IP形象,那么最终学生认同的是这个形象而非具体的老师。

2.2 声音篇

讲完图片接下来我们讲讲声音与ai的结合点。目前使用声音最主流的应用就是语音评测,也就是学生说一句话,机器给打分,典型代表是讯飞、流利说、一起作业、盒子鱼……

主要的契机是不论是学生还是家长,还是学校和教委都逐渐对于英语口语这件事情重视起来了。虽然高考表面上是“弱化英语”了,但实际上如果要上名校,英语,尤其英语口语所占的比重是要比过去更大。而目前绝大多数市面上的口语学习App的口语评测的水平就是评判规定的一句话的发音准确度,或者是半开放式的交流。而真正的难点是评估开放性的对话的好坏——其实这部分更多还是下一部分要讲的文字识别。讯飞已经在这个方向上与国家多个省签约合作,尝试做高考开放式口语题目的自动批改,这也与接下来要介绍的NLP有直接关联。

声音最大的未来应用一个是做出人耳分辨不出来的语音合成。目前Google的Wavenet已经接近这个水平只不过运算起来非常慢,百度近期也对这个结果的性能进行了优化。另一个则是把语音识别率再提升一个新的档次。这两项工作都是在可预见的两三年内会实现并且普及起来的。到时候,配合上虚拟的IP形象,许多一线教师就会逐渐意识到自己可能会从“台前”转向“幕后”,甚至面临着失业的风险。

另外,声音识别在音乐教学这个细分领域也会有一些应用,这块就不展开了。

2.3 文字篇(NLP)

文字处理,也就是所谓自然语言处理(简称NLP),在传统教育的最大应用就是作文的自动批改,由于市场较小,所以在这里也就不展开了。

我们来思考一件事情,人类99%的知识都是以文字的形势记录下来的。

老师讲课,最重要不是他的面孔和他的音色,而是他所说的话。同理,真正的在线教育与AI的最重要的结合点既不是声音,也不是图像,而是文字。在我们之前的论述里,只要文字确定好了,我们就可以合成出最磁性的声音配合最帅气的虚拟脸蛋,所有在线教育并不需要“固定的视频”。如果讲课内容,也就是文字是变化的,那就相当于每一个学生会有一个针对性的一对一老师。

AI对于在线教育要解决的大问题是,如何把课本上死的知识,变成老师给学生的对话。这里的技术挑战就非常多了,包括:

1.自动解题能力——能够根据题目自动得出详细解析。

2.作业智能批改能力——这里说的不只是批改选择判断题,而是能够对学生的做题过程进行批改。

3.智能答疑能力——能够回答学科相关问题。

4.自适应对话能力——感知到学生的学习状态并且不断地给出相应的互动。(请参照下文)

目前这四个问题的所有解决方案都是基于人工编写的规则,而不是利用AI。但是这方面科技发展也非常快,国外已经有Geosolver在试图解决第一道题,国内也有团队在试图做“高考机器人”。

2.4 自适应篇

目前市面上的自适应产品,都是基于人工梳理的教学模型+简单的数学建模——产品形态也比较简单,根据学生做题的对错,评估其知识点的掌握程度。其中的典型就是Knewton、可汗学院和猿题库,他们所采用的IRT算法早已开源。实践中,真正耗时耗力的是教研,而且这还是在做得非常粗糙的情况下。毕竟绝大多数自适应学习产品只关心一道题的对错,而无法判别具体“为什么”错了——同一道填空题,不同的学生答案老师一眼就能看出是哪一个知识点掌握不到家,而系统一遍就只能归结于固定的一个知识点。至于证明题,解答题更是现有自适应产品无法解决的。

所以真正的自适应的依赖条件依然是之前所提到的NLP/文字处理能力。只有当算法能够看到题目知道正确答案,看到题目知道出题人的意思,看到错误的答案就知道哪个知识点掌握不到家时,在线教育就会出现全新的洗牌,自适应也会成为所有学习的主流方式。

总结:随着人工智能的发展和普及,传统的学习方式会被彻底颠覆,每一个学生会有一个一对一的专业AI老师,能够让其学会各种知识,不再受家庭出身、学校和课本的限制。将语音合成,虚拟IP再加上nlp和自适应学习结合形成的互动式学习产品存在着巨大的商业前景。当然这个愿景确实距离我们有一些遥远,在这个愿景实现之前,我们依然不得不勒紧裤腰带购买高昂的学区房。然而现在的深度学习已经在为教育产业提供工具,有一些企业会捷足先登,有一些企业则会踟蹰不前。最终的赢家既不是那些做教学最好的企业,也不是那些AI研发能力最好的企业,而是那些能够把技术和教学和产品和推广融合好的企业。这也是我们最期待投资的企业。今天就讲到这里,我们下周再见。

星河融快(ID:rongkuai888)将通过专业的分析,持续与你分享“有趣的”产业互联网干货。欢迎你在下方留言和我们分享有趣的观点,自荐或推荐优质产业互联网项目,同时也欢迎你来上地18号和我们聊聊。

来源: 芥末堆